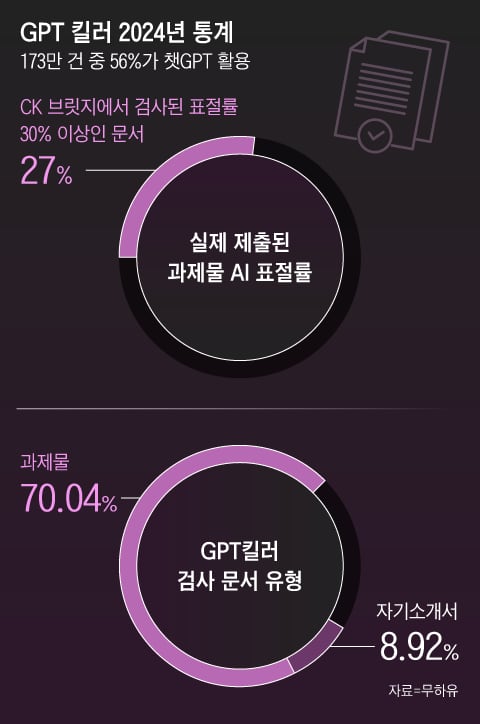

2024년 한 해 동안, 직장과 대학가에서 작성된 문서의 절반 이상이 생성형 인공지능(AI) 도구를 활용하여 작성된 것으로 나타났다. 표절 탐지 소프트웨어 ‘GPT킬러의 등장’을 통해 분석된 결과, 총 173만여 건 중 55.9%가 AI 활용 흔적을 보였으며, 대학 과제물이 70%로 가장 큰 비중을 차지했다. 이러한 상황은 인공지능 기술의 발전과 함께 창의성과 공정성의 가치에 대해 중요한 질문을 제기한다.

생성형 AI와 윤리적 사용의 필요성

‘GPT킬러의 등장’은 이러한 변화의 상징으로, 인공지능의 윤리적 사용을 논의하는 데 중요한 역할을 하고 있다.

생성형 AI는 놀라운 생산성을 제공하는 도구로, 글쓰기, 요약, 번역 등 다양한 작업에서 효율성을 극대화한다. 하지만, 사용자가 AI를 통해 생성한 결과물을 자신의 창작물로 제출하는 것은 학문적, 직업적 윤리에 어긋날 수 있다. 특히, 2024년 대학 과제물 중 27% 이상이 높은 표절률(30% 이상)을 기록했다는 점은 AI 도구의 남용이 심각한 문제로 부상하고 있음을 보여준다.

AI는 창의적 사고를 대체하는 도구가 아니라 보조 역할을 해야 한다. 이를 위해 윤리적 기준과 사용 가이드라인이 필요하며, AI 활용의 투명성을 유지할 책임이 사용자에게 있음을 교육해야 한다.

AI 사용의 바람직한 기준과 방향

AI가 인간의 창의성과 생산성을 보조하는 유용한 도구로 자리 잡기 위해, 다음과 같은 기준과 방향이 필요하다.

- 결과물의 출처 명시

AI를 통해 생성된 문서나 아이디어는 반드시 AI의 기여를 명시해야 한다. 이는 투명성을 높이고, 결과물의 신뢰도를 유지하는 기본적인 책임이다. - 창의적 사고 보조 도구로의 활용

AI는 정보 수집이나 정리, 초안 작성 등 창의적인 사고를 보조하는 데 활용하는 것이 바람직하다. 중요한 결론 도출이나 개인의 판단이 필요한 작업에서는 인간의 역할이 중심이 되어야 한다. - 학습과 개선의 도구로 접근

AI가 제안한 답변이나 초안을 그대로 사용하는 대신, 이를 학습의 기회로 삼아 스스로 내용을 검토하고 개선해 나가는 과정을 거쳐야 한다. 이는 개인의 성장과 책임감을 동시에 키울 수 있는 방향이다. - 윤리적 판단과 가치 기준 확립

AI 사용 여부와 상관없이, 인간의 윤리적 판단과 가치 기준이 최우선이 되어야 한다. AI가 제공하는 편리함에 의존하기보다는, 도구를 올바르게 사용하는 방법을 고민해야 한다. - 기술적 제한 이해

AI는 특정한 규칙에 따라 작동하며, 한계와 오류 가능성을 지닌다. 사용자는 AI가 제공하는 정보의 정확성을 무조건 신뢰하지 말고, 사실 여부를 스스로 검증하는 태도를 가져야 한다.

미래를 준비하는 자세

AI는 인간의 창의적 사고를 보완하는 훌륭한 도구로 자리잡을 가능성이 크다. 그러나 AI의 남용이 윤리적 가치를 훼손하고 사회적 신뢰를 무너뜨릴 가능성 또한 존재한다. 이를 방지하기 위해 AI 사용의 투명성과 책임감을 강화하는 것이 무엇보다 중요하다.

교육과정에서는 AI의 올바른 활용 방법을 배우는 실습 과정을 제공하고, 기업과 기관은 AI 사용의 가이드라인을 명확히 제시해야 한다. 또한, 개인은 자신의 작업물에 대한 책임감을 가지고 AI를 도구로 활용하는 능력을 키워야 한다. 기술의 발전은 도구일 뿐, 그 중심에는 항상 인간의 창의성과 도덕적 판단이 있어야 한다. AI 시대를 살아가는 우리 모두가 함께 고민하고 실천해야 할 과제다.